En matière de sécurité, on peut faire confiance au secteur bancaire pour ne pas se précipiter sur les dernières versions. Découvrez pourquoi Mastercard n’utilise pas OAuth 2.0 et continue ainsi d’utiliser OAuth 1.0a :

https://developer.mastercard.com/blog/why-mastercard-doesnt-use-oauth-20

On le savait que le temps de chargement des pages a un effet sur l’algorithme de Google dans le cadre du positionnement. Mais c’est désormais clairement annoncé ici, surtout sur mobile :

https://webmaster-fr.googleblog.com/2018/01/vitesse-chargement-pages-critere-positionnement.html?m=1

Voici le dernier exemple d’optimisations réalisées sur un site dont nous nous occupons (mise en cache des articles du blog, de certains appels aux serveurs situés chez le client, compression et autres optimisations à la fois côté serveur et côté site, montée de version de Ruby et Rails…) :

Créateur du framework « Scrapy », Scrapinghub nous explique ce qu’ils ont retenu de l’extraction de données à grande échelle (en l’occurence 100 milliards de pages de produits depuis 2010). Au sommaire : contournements de mesure anti-bot, qualité des données, vitesse de scraping, etc. :

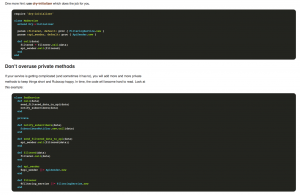

Paweł Świątkowski (@katafrakt_pl), de chez Boostcom, nous explique sa façon d’écrire des Service Objects pour refactoriser une application réalisées avec Ruby on Rails :

WebScore AI scanne votre site web et vous indique s’il est attrayant d’un point de vue technique (le code de la page répond-t-il aux normes importantes de l’Internet moderne ?) mais également d’un point de vue usage (conception du site et lisibilité de son contenu). En entrainant un réseau de neurones ont été identifiées 1000 fonctionnalités qui rende un site web parfait. WebScore AI est désormais en accès public afin de faciliter sa progression, essayez-le :